Blogg

Här finns tekniska artiklar, presentationer och nyheter om arkitektur och systemutveckling. Håll dig uppdaterad, följ oss på LinkedIn

Här finns tekniska artiklar, presentationer och nyheter om arkitektur och systemutveckling. Håll dig uppdaterad, följ oss på LinkedIn

Samma vecka som några av mina kollegor besökte GSAS i Barcelona så hade jag möjligheten och nöjet att besöka World Summit AI 2023 i Amsterdam, där vädret inte låter sig jämföras med Katalonien men jag tror att konferensinnehållet var minst lika bra! Därför tänkte jag, utifrån en handfull anteckningar, mitt bristfälliga minne och på mitt eget fullkomligt otillräckliga sätt, försöka dela med mig av några höjdpunkter, teman och reflektioner från konferensen.

Men först några ord om vad World Summit AI (WSAI) är för en konferens och varför jag åkte dit. WSAI arrangerades i år för 8:e året i rad och drog omkring 4.000 besökare till Taets and Arts eventlokaler strax utanför Amsterdam. Bland talarna så märktes namn både från stora teknikbolag som Amazon, IBM, Mastercard och NVIDIA, men även representanter från statliga och internationella organisationer som NASA, WEF, FN, ett par olika ministrar, samt akademia - så verkligen ett brett utbud av intressanta talare.

Så vad gjorde jag där? Förutom att mitt deltagande var en del av en informationsinsamlingsoperation organiserad av Callista och utförd av mig för att kunna producera denna bloggpost och på så vis sprida så mycket information som möjligt till er, våra läsare, så var detta även ett utmärkt tillfälle för att höra vad människor i branchen säger: vad är på gång? Vilka utmaningar står vi inför? Vilka nyckelfaktorer krävs för att lyckas?

Vad gör jag här egentligen?

Vad gör jag här egentligen?

Jag tror helt ärligt att om någon talare försökt välja ett ämne som inte hade med “generative AI” i titeln så sållades han eller hon bort, punkt. Eller nu ljuger jag faktiskt, det fanns en presentation, om kvantdatorer och AI, som inte nämnde generativ AI i titeln men som ändå kom med på programmet. Att generativ AI var årets hetaste trend anser jag dock vara fastställt bortom allt rimligt tvivel.

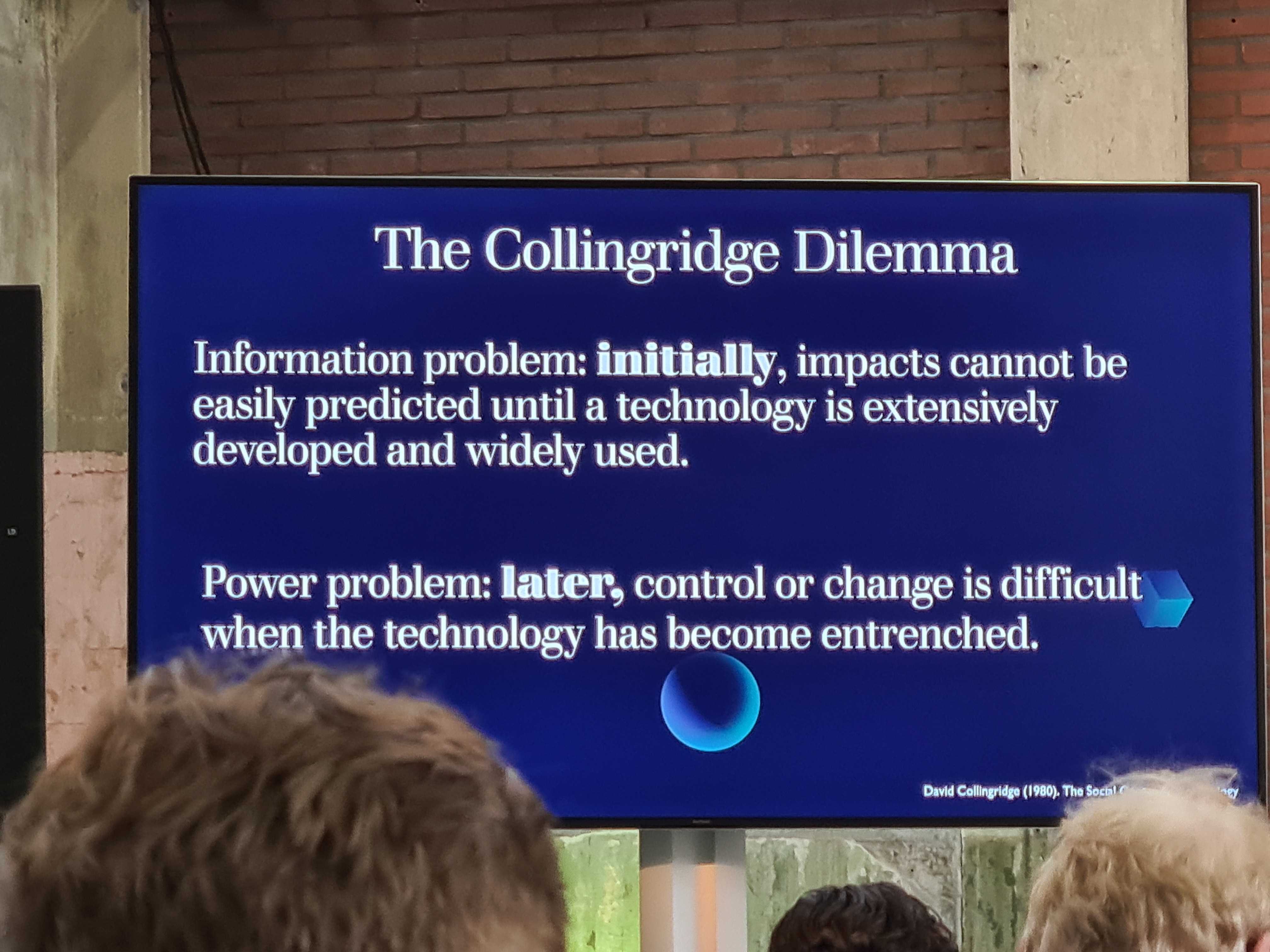

Men nya innovationer och framsteg inom AI är som bekant inte en ensidig välsignelse, och detta är inte mindre sant när det kommer till generativ AI. Ökade risker med så kallade “deep fakes” och andra välkända risker diskuterades utförligt i olika paneler och presentationer under konferensen. En talande tystnad spred sig dock när frågan om hur vi kan bemöta dessa risker restes, för att efter ett tag besvaras med en variant av “det är viktigt att alla är snälla mot varandra”, vilket vi ju vet att vi inte alltid är.

Har vi öppnat Pandoras ask?

Har vi öppnat Pandoras ask?

Något annat som dök upp mycket under konferensen och som var nytt för mig gällde en kommande EU lagstiftning rörande AI: European Union AI Act (EUAIA), en GDPR för AI som fortfarande arbetas på men som förväntas ratificeras någongång runt 2025 och som kommer kunna leda till att företag som på ett oetiskt sätt använder AI kan bötfällas med upp till €30M eller 6% av företagets globala omsättning. Eftersom lagstiftningen inte är färdig än så kan inte säga så mycket mer om den, men detta är något att hålla utkik efter.

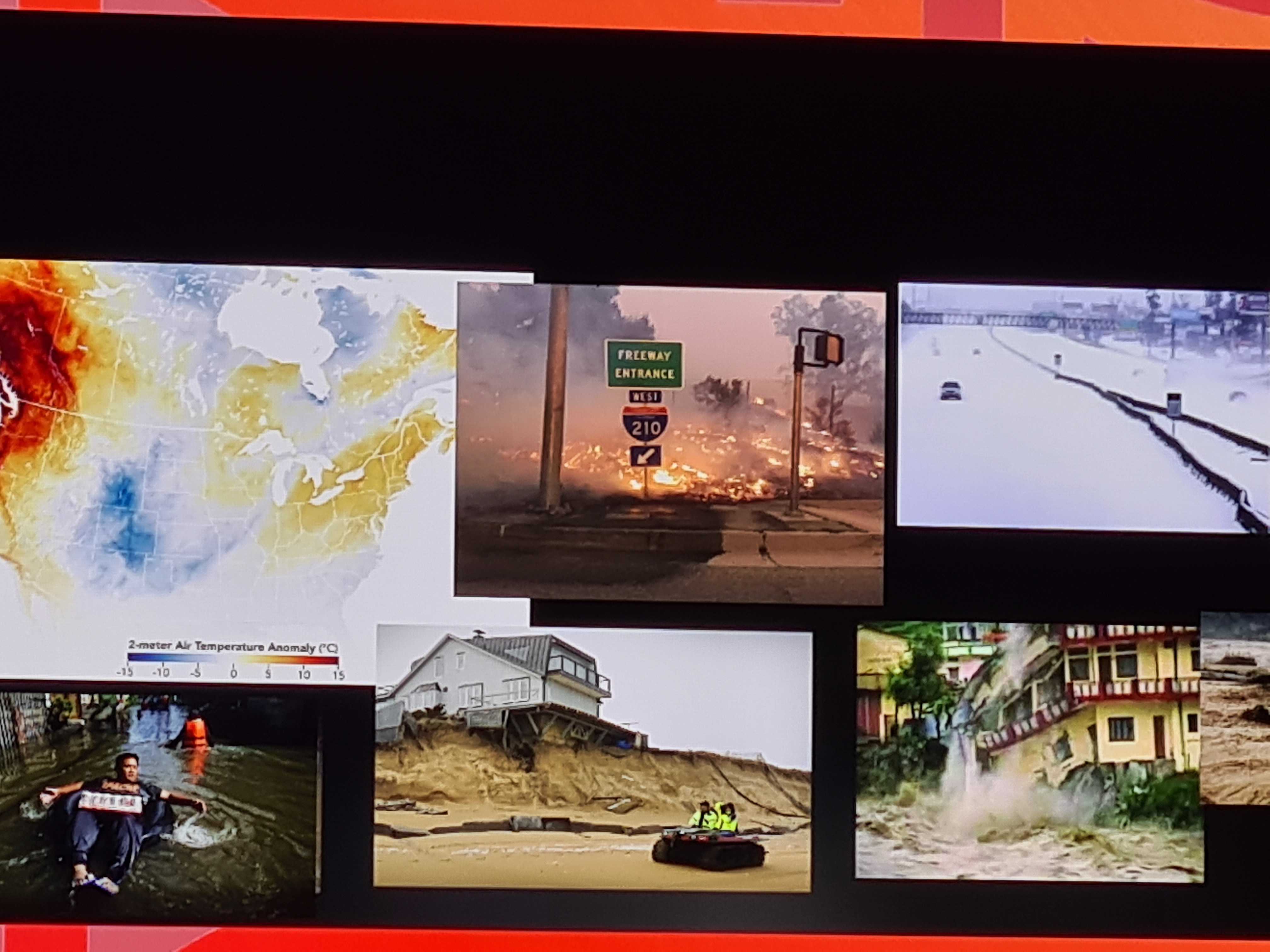

Relaterat till EUAIA diskuterades hur de stora spelarna (USA, Kina, EU och i viss mån Indien) alla just nu tävlar om att bli ledande inom AI (och EU ligger nog inte bäst till, om vi är ärliga) och huruvida EU:s iver att reglera på detta område kommer vara en för- eller nackdel. I övrigt vad gäller de stora penseldragen så var det saker som är allmänt kända: AI ger oss nya och kraftfulla verktyg för att hjälpa oss bemöta några av de stora världsproblemen: klimatförändringar, globala varutransporter, matproduktion, etc. men som alla verktyg så kan det i fel händer användas på ett skadligt sätt som massövervakning, desinformationskampanjer, etc.

Kan AI hjälpa oss bemöta problem som klimatförändringar, säker matproduktion och internationella transporter?

Kan AI hjälpa oss bemöta problem som klimatförändringar, säker matproduktion och internationella transporter?

Intressant var att ingen jag hörde verkade särskilt oroad över att någon superintelligent generell intelligens skulle ta över världen. Ett argument för att så inte skulle ske var att de största AI modellerna, som t.ex. LLMs (Large Language Model), dras med ett problem att kapaciteten i dessa modeller tycks plana ut, så att det till slut krävs väldigt mycket mer data och datorkraft för att förbättra en sådan modell även bara lite, lite grann.

Ingen dystopisk framtidsvision, bilden föreställer är en vanlig torsdagsmorgon i oktober i Amsterdam

Ingen dystopisk framtidsvision, bilden föreställer är en vanlig torsdagsmorgon i oktober i Amsterdam

Det fanns massor av intressanta föredrag på konferensen, men då det var sju parallella spår av presentationer och jag bara kunde vara på en plats i taget - för att få någon hjälp av kvantfysiken att superpositionera mig på flera platser samtidigt så verkar det som att jag först skulle behövt kyla ner mig själv till nära den absoluta nollpunkten, och om jag då, i det superpositionerade tillståndet observerats av någon annan deltagare så antar jag att jag skulle fastnat på den platsen. Vid den tidpunkten med all säkerhet kraftigt nedkyld och troligtvis även död.

Därför försökte jag noggrant välja ett litet urval av extra intressanta sessioner och från dem plocka ut ett par höjdpunkter att dela med er. Den första presentationen jag kommer att tänka på som jag tyckte var väldigt intressant var från iris.ai som jobbar på en modell för att styra en LLM så att den faktakontrollerar sig själv. Något som många uppmärksammat som ett problem är att t.ex. ChatGPT kan framstå som väldigt säker på sin sak och resonera på ett sätt som vid en första anblick verkar trovärdigt, men som vid en noggrannare analys visar sig vara ren rapparkalja, ett fenomen som kommit att kallas “att modellen hallucinerar”. Detta problem försöker de alltså lösa genom att använda en kunskapsgraf som de byggt upp under flera års tid och som idag har flera miljoner medicinska fakta. I dagsläget handlar det alltså mest om att kunna använda en faktakontrollerad version av ChatGPT i medicinska sammanhang.

Nästa guldkorn i form av en presentation kom från Radicalbit och var faktiskt den som följde direkt inpå den från iris.ai. Denna presentation handlade om hur många modeller lider av det som kallas för “data drift” och “concept drift”. Nya begrepp för mig, men om jag kort skulle försöka förklara dem så är det någonting såhär: många modeller tränas upp med något historiskt träningsdataset som man hoppas kan generalisera framtida data. Men om vår nya data rör sig längre och längre bort från hur den historiska datan såg ut och som vi använde för att träna vår modell så kommer vår modell till slut få problem att korrekt behandla den nya datan. Detta är data drift, där vår data idag inte ser likadan ut som den gjorde för kanske ett antal år sedan.

Concept drift, ett närbesläktat fenomen, men här handlar det om att vi idag gör andra bedömningar av koncept än vad vi gjorde när vi tränade modellen. Vi kanske har en modell som ska identifiera brister på någon produkt, och när vi skapade modellen så hade vi ett gränsvärde för när en produkt ansågs vara otjänlig, men idag så har vi ett mycket lägre gränsvärde. Hur hanterar man då dessa problem? Det första man bör göra är att vara medveten om att dessa saker kan uppstå, världen förändras hela tiden. Sedan kan det vara lite situationsberoende, men man kan fundera på om man behöver ha en online-modell som uppdaterar sig kontinuerligt eller om man behöver på något sätt förbättra sin träningsdata.

Sista höjdpunkten som jag vill nämna var från SambaNova som har utvecklat sin egen hård- och mjukvarukonfiguration för maskininlärning. I väldigt generella termer så har de utvecklat hårdvara kapabel att träna flera maskininlärningsmodeller parallellt, vilket möjliggör en divide-and-conquer taktik för att bygga kraftfulla AI system. Parallellt med detta så jobbar de på att porta publika ramverk för maskininlärning och ML modeller så att de kan användas på SambaNovas hårdvara. Jag lyfter denna presentation till status “guldkorn” helt enkelt för att jag tycker det har en mycket hög coolhetsfaktor, inte nödvändigtvis praktiskt för det stora flertalet.

Detta betyder med andra ord att en presentation om kvantdatorer och AI inte kvalade in på den åtråvärda listan, vilket jag kan förstå chokerar många, men till dem vill jag bara säga att även om ämnet har extrem coolhetsfaktor så var själva presentationen på en väldigt allmän nivå vilket tyvärr sänkte betyget, men vi hoppas såklart på en ny chans nästa år.

Fullt med företag som visade upp sig i utställarhallen

Fullt med företag som visade upp sig i utställarhallen

Jag vill avsluta den här bloggposten med några av mina personliga reflektioner från konferensen i sin helhet. Några av dessa kan framstå som kritik, men jag vill kraftigt understryka att mitt totala omdöme om konferensen är att den var fantastiskt inspirerande med informativt och intressant innehåll, så jag kan utan tvekan rekommendera andra som vill gå på den kommande år att besöka den!

“Första intrycket består” heter det, och tyvärr var inte det första intrycket det bästa möjliga. För att ta sig från Amsterdam central till konferensen som låg en bit utanför centrum arrangerades bussar, vilket var trevligt, men att hitta var dessa bussar avgick ifrån var inte lika enkelt och vi var många besökare som mer och mer frustrerat irrade omkring runt Amsterdam central för att försöka förstå varifrån bussen gick. Det löste sig såklart till slut, men det skapade onödig frustration hos många och det hade varit så enkelt att lösa med en skylt, liten flagga eller en volontär som kunde peka folk rätt.

En förmodligen mer relevant reflektion från konferensen rör typen av presentationer. Överlag så låg presentationerna på en generell/business nivå: mycket få tekniska detaljer, inga demos, ingen kod. Nu är inte detta en utvecklarkonferens så avsaknaden av live-kodning framstår inte som så anmärkningsvärt, men jag hade personligen gärna sett lite mer av demos och liknande. En sista reflektion rör besökarprofilen på konferensen. Jag kände mig först lite som en udda fågel på konferensen då jag inte jobbar med AI utan bara har ett intresse för ämnet, men även om majoriteten av besökarna troligen jobbar aktivt med AI så var besöksprofilen ganska bred. Jag möte andra utvecklare, akademiker inom olika områden (inte direkt relaterade till AI), samt någon enstaka chef.

Tack Amsterdam för denna gång!

Tack Amsterdam för denna gång!